| Главная » Статьи » HI-TECH » ВСЕ О ХОСТИНГЕ И ПО |

Файл robots.txt — текстовый файл в формате .txt, ограничивающий поисковым роботам доступ к содержимому на http-сервере. Как определение, Robots.txt — это стандарт исключений для роботов, который был принят консорциумом W3C 30 января 1994 года, и который добровольно использует большинство поисковых систем. Файл robots.txt состоит из набора инструкций для поисковых роботов, которые запрещают индексацию определенных файлов, страниц или каталогов на сайте. Рассмотрим описание robots.txt для случая, когда сайт не ограничивает доступ роботам к сайту. Простой пример robots.txt:

Файл robots.txt необходимо загрузить в корневой каталог вашего сайта, чтобы он был доступен по адресу:

Если файл доступен, то вы увидите содержимое robots.txt в браузере. Для чего нужен robots.txt Roots.txt для сайта является важным аспектом поисковой оптимизации. Зачем нужен robots.txt? Например, в SEO robots.txt нужен для того, чтобы исключать из индексации страницы, не содержащие полезного контента и многое другое. Как, что, зачем и почему исключается уже было описано в статье про запрет индексации страниц сайта, здесь не будем на этом останавливаться. Нужен ли файл robots.txt всем сайтам? И да и нет. Если использование robots.txt подразумевает исключение страниц из поиска, то для небольших сайтов с простой структурой и статичными страницами подобные исключения могут быть лишними. Однако, и для небольшого сайта могут быть полезны некоторые директивы robots.txt, например директива Host или Sitemap, но об этом ниже. Как создать robots.txt Поскольку robots.txt — это текстовый файл, и чтобы создать файл robots.txt, можно воспользоваться любым текстовым редактором, например Блокнотом. Как только вы открыли новый текстовый документ, вы уже начали создание robots.txt, осталось только составить его содержимое, в зависимости от ваших требований, и сохранить в виде текстового файла с названием robots в формате txt. Все просто, и создание файла robots.txt не должно вызвать проблем даже у новичков. О том, как составить robots.txt и что писать в роботсе на примерах покажу ниже. Cоздать robots.txt онлайн Вариант для ленивых — создать роботс онлайн и скачать файл robots.txt уже в готовом виде. Создание robots txt онлайн предлагает множество сервисов, выбор за вами. Главное — четко понимать, что будет запрещено и что разрешено, иначе создание файла robots.txt online может обернуться трагедией, которую потом может быть сложно исправить. Особенно, если в поиск попадет то, что должно было быть закрытым. Будьте внимательны — проверьте свой файл роботс, прежде чем выгружать его на сайт. Все же пользовательский файл robots.txt точнее отражает структуру ограничений, чем тот, что был сгенерирован автоматически и скачан с другого сайта. Читайте дальше, чтобы знать, на что обратить особое внимание при редактировании robots.txt. Редактирование robots.txt После того, как вам удалось создать файл robots.txt онлайн или своими руками, вы можете редактировать robots.txt. Изменить его содержимое можно как угодно, главное — соблюдать некоторые правила и синтаксис robots.txt. В процессе работы над сайтом, файл роботс может меняться, и если вы производите редактирование robots.txt, то не забывайте выгружать на сайте обновленную, актуальную версию файла со всем изменениями. Далее рассмотрим правила настройки файла, чтобы знать, как изменить файл robots.txt и «не нарубить дров». Правильная настройка robots.txt Правильная настройка robots.txt позволяет избежать попадания частной информации в результаты поиска крупных поисковых систем. Однако, не стоит забывать, что команды robots.txt не более чем руководство к действию, а не защита. Роботы надежных поисковых систем, вроде Яндекс или Google, следуют инструкциям robots.txt, однако прочие роботы могут легко игнорировать их. Правильное понимание и применение robots.txt — залог получения результата. Чтобы понять, как сделать правильный robots txt, для начала необходимо разобраться с общими правилами, синтаксисом и директивами файла robots.txt. Правильный robots.txt начинается с директивы User-agent, которая указывает, к какому роботу обращены конкретные директивы. Примеры User-agent в robots.txt:

Пример robots.txt с несколькими вхождениями User-agent:

Пример неправильного перевода строки в robots.txt:

«*». Кроме того, важно соблюдать правильный порядок и сортировку команд в robots.txt при совместном использовании директив, например «Disallow» и «Allow». Директива «Allow» — разрешающая директива, является противоположностью команды robots.txt «Disallow» — запрещающей директивы. Пример совместного использования директив в robots.txt:

Прошлый пример robots.txt в правильной сортировке:

Еще один правильный пример robots.txt с совместными директивами:

Директивы «Allow» и «Disallow» можно указывать и без параметров, в этом случае значение будет трактоваться обратно параметру «/». Пример директивы «Disallow/Allow» без параметров:

Для правильного составления robots.txt необходимо точно указывать в параметрах директив приоритеты и то, что будет запрещено для скачивания роботам. Более полно использование директив «Disallow» и «Allow» мы рассмотрим чуть ниже, а сейчас рассмотрим синтаксис robots.txt. Знание синтаксиса robots.txt приблизит вас к тому, чтобы создать идеальный robots txt своими руками. Синтаксис robots.txt Роботы поисковых систем добровольно следуют командам robots.txt — стандарту исключений для роботов, однако не все поисковые системы трактуют синтаксис robots.txt одинаково. Файл robots.txt имеет строго определённый синтаксис, но в то же время написать robots txt не сложно, так как его структура очень проста и легко понятна. Вот конкретные список простых правил, следуя которым, вы исключите частые ошибки robots.txt:

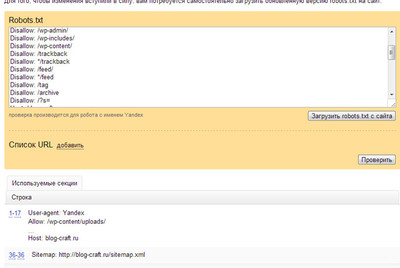

В роботсе должно быть указано строго только то, что нужно, и ничего лишнего. Не думайте, как прописать в robots txt все, что только можно и чем его заполнить. Идеальный robots txt — это тот, в котором меньше строк, но больше смысла. «Краткость — сестра таланта». Это выражение здесь как нельзя кстати. Как проверить robots.txt Для того, чтобы проверить robots.txt на корректность синтаксиса и структуры файла, можно воспользоваться одной из онлайн-служб. К примеру, Яндекс и Google предлагают собственные сервисы анализа сайта для вебмастеров, которые включают анализ robots.txt: Проверка файла robots.txt в Яндекс.Вебмастер: Проверка файла robots.txt в Google: Для того, чтобы проверить robots.txt онлайн необходимо загрузить robots.txt на сайт в корневую директорию. Иначе, сервис может сообщить, что не удалось загрузить robots.txt. Рекомендуется предварительно проверить robots.txt на доступность по адресу где лежит файл, например: ваш_сайт.ru/robots.txt. Кроме сервисов проверки от Яндекс и Google, существует множество других онлайн валидаторов robots.txt. Robots.txt vs Яндекс и Google Есть субъективное мнение, что указание отдельного блока директив «User-agent: Yandex» в robots.txt Яндекс воспринимает более позитивно, чем общий блок директив с «User-agent: *». Аналогичная ситуация robots.txt и Google. Указание отдельных директив для Яндекс и Google позволяет управлять индексацией сайта через robots.txt. Возможно, им льстит персонально обращение, тем более, что для большинства сайтов содержимое блоков robots.txt Яндекса, Гугла и для других поисковиков будет одинаково. За редким исключением, все блоки «User-agent» будут иметь стандартный для robots.txt набор директив. Так же, используя разные «User-agent» можно установить запрет индексации в robots.txt для Яндекса, но, например не для Google. Отдельно стоит отметить, что Яндекс учитывает такую важную директиву, как «Host», и правильный robots.txt для яндекса должен включать данную директиву для указания главного зеркала сайта. Подробнее директиву «Host» рассмотрим ниже. Запретить индексацию: robots.txt Disallow Disallow — запрещающая директива, которая чаще всего используется в файле robots.txt. Disallow запрещает индексацию сайта или его части, в зависимости от пути, указанного в параметре директивы Disallow. Пример как в robots.txt запретить индексацию сайта:

В параметре директивы Disallow допускается использование специальных символов * и $: * — любое количество любых символов, например, параметру /page* удовлетворяет /page, /page1, /page-be-cool, /page/kak-skazat и т.д. Однако нет необходимости указывать * в конце каждого параметра, так как например, следующие директивы интерпретируются одинаково:

Если закрыть индексацию сайта robots.txt, в поисковые системы могут отреагировать на так ход ошибкой «Заблокировано в файле robots.txt» или «url restricted by robots.txt» (url запрещенный файлом robots.txt). Если вам нужно запретить индексацию страницы, можно воспользоваться не только robots txt, но и аналогичными html-тегами:

Allow — разрешающая директива и противоположность директиве Disallow. Эта директива имеет синтаксис, сходный с Disallow. Пример, как в robots.txt запретить индексацию сайта кроме некоторых страниц:

Disallow и Allow с пустым значением параметра Пустая директива Disallow:

Директива Host служит для указания роботу Яндекса главного зеркала Вашего сайта. Из всех популярных поисковых систем, директива Host распознаётся только роботами Яндекса. Директива Host полезна в том случае, если ваш сайт доступен по нескольким доменам, например:

Пример robots.txt с указанием главного зеркала:

Директива Host в файле robots.txt может быть использована только один раз, если же директива Хост будет указана более одного раза, учитываться будет только первая, прочие директивы Host будут игнорироваться. Если вы хотите указать главное зеркало для робота Google, воспользуйтесь сервисом Google Инструменты для вебмастеров. Карта сайта: robots.txt sitemap При помощи директивы Sitemap, в robots.txt можно указать расположение на сайте файла карты сайта sitemap.xml. Пример robots.txt с указанием адреса карты сайта:

Директива Clean-param Директива Clean-param позволяет исключить из индексации страницы с динамическими параметрами. Подобные страницы могут отдавать одинаковое содержимое, имея различные URL страницы. Проще говоря, будто страница доступна по разным адресам. Наша задача убрать все лишние динамические адреса, которых может быть миллион. Для этого исключаем все динамические параметры, используя в robots.txt директиву Clean-param. Синтаксис директивы Clean-param:

Данная инструкция позволяет снизить нагрузку на сервер, если роботы слишком часто заходят на ваш сайт. Данная директива актуальна в основном для сайтов с большим объемом страниц. Пример robots.txt Crawl-delay:

В данном случае мы «просим» роботов яндекса скачивать страницы нашего сайта не чаще, чем один раз в три секунды. Некоторые поисковые системы поддерживают формат дробных чисел в качестве параметра директивы Crawl-delay robots.txt. Комментарии в robots.txt Комментарий в robots.txt начинаются с символа решетки — #, действует до конца текущей строки и игнорируются роботами. Примеры комментариев в robots.txt:

Пример файла robots.txt Рассмотрим простенький пример файла robots.txt, чтобы лучше разобраться в особенностях его синтаксиса:

Теперь разберем описанный пример. Файл состоит из трех блоков: первый для Яндекса, второй для всех поисковых систем, а в третьем указан адрес карты сайта (применяется автоматически для всех поисковиков, поэтому указывать «User-Agent» не нужно). Яндексу мы разрешили индексировать папку «folder1» и все ее содержимое, но запретили индексировать документ «file1.html», находящийся в корневом каталоге на хостинге. Также мы указали главный домен сайта яндексу. Второй блок – для всех поисковиков. Там мы запретили документ «document.php», а также папки «folderxxx», «folderyyy/folderzzz» и «feed». Обратите внимание, что мы запретили в втором блоке команд к индексу не всю папку «folderyyy», а лишь папку внутри этой папки – «folderzzz». Т.е. мы указали полный путь для «folderzzz». Так всегда нужно делать, если мы запрещаем документ, находящийся не в корневом каталоге сайта, а где-то внутри других папок. Созданный файл роботс можно проверить на работоспособность в панели вебмастеров Яндекса. Если в файле вдруг обнаружатся ошибки, то яндекс это покажет. Обязательно создайте файл robots.txt для вашего сайта, если его у вас до сих пор нету. Это поможет развиваться вашему сайту в поисковых системах. Также можете почитать еще одну нашу статью про способы запрета индексации методом мета-тегов и .htaccess. Правильное использование тега и атрибута noindex, nofollow – самый первый шаг в грамотной сео-оптимизации. Ведь noindex и nofollow играют огромную роль при передаче веса с одного сайта на другой. Тег noindex (ноиндекс) Как можно догадаться, тег ноиндекс используется для запрета индексации какой-то части html-кода (картинки и ссылки нельзя закрыть от индексации этим тегом, а лишь текст). Если все же закрыть анкор с ссылкой этим тегом, то не проиндексируется лишь анкор, а ссылка все равно попадет в индекс. Однако тег не является валидным, поэтому некоторые html-редакторы отказываются его воспринимать (в частности, визуальный редактор в wordpress удаляет noindex). Но тегу можно придать валидность:

Не стоит путать обычный тег <noindex> с мета-тегом noindex, прописываемым вначале страницы, их задачи разные. Простой тег запрещает для индексации только ту часть кода страницы, которая находится между открывающимся <noindex> и закрывающимся </noindex> тегами. Пример:

Кстати, школа Start Up ошибается, когда советует закрывать все ссылки тэгами nofollow noindex, но об этом чуть ниже. Тег работает безотказно: вся текстовая информация внутри него не попадает в индекс яндекса. Однако некоторые оптимизаторы утверждают, что порой текст внутри ноиндекс индексируются – увы, такое действительно бывает. Дело в том, что яндекс все же изначально индексирует весь html-код, даже тот, что внутри тега, но потом проводит фильтрацию. Поэтому первое время действительно текст внутри ноиндекс может быть проиндексирован, но вскоре тег срабатывает и «все лишнее» вылетает из индекса. Кстати, соблюдать вложенность тегов noindex совершенно необязательно — тег сработает даже при неправильной вложенности (это написано в справке Яндекса): Внимание!!! Используя открывающийся тег (<noindex>), не забудьте поставить закрывающийся — (</noindex>), иначе весь текст, следующий после <noindex> не будет проиндексирован. Когда нужно использовать ноиндекс, а когда нет Этот тэг стоит использовать в тех случаях, когда мы хотим спрятать от яндекса ненужную часть html-кода страницы, дабы в индекс робота этой поисковой системы не лезла «грязь». Основываясь на этом, можно сказать, что noindex стоит использовать, чтобы:

Атрибут nofollow предназначен для закрытия от индексации ссылок как для Гугла, так и для Яндекса. Он используется для того, чтобы не передавать вес со ссылающегося сайта на ссылаемый. То, что Яндекс не знает о нофоллоу — миф, убедитесь сами — ссылка. Кстати, тег nofollow не сохраняет вес на странице — если какая-та ссылка «нофоллоу», то вес по ней не перетекает, а сгорает, либо, если есть другие не закрытые данным тегом ссылки на странице, перераспределяется между ними. Кстати, отсюда следует, что если у вас на странице есть хотя бы одна активная внешняя гиперссылка, то вес со страницы уходит — поэтому не стоит закрывать все внешние ссылки тегом nofollow. Вес вы все равно не сохраните (он сгорит, если все внешние ссылки закрыть нофоллоу). Принципиальное отличие между noindex nofollow: ноиндекс – тег, закрывающий от индексации текст, нофоллоу – атрибут тега <a>, запрещающий передавать вес по ссылке. Пример использования нофоллоу:

Использование nofollow Использовать атрибут nofollow нужно в том случае, если нет необходимости в передаче веса со ссылающегося сайта на тот web-ресурс, на который ведет ссылка. Поэтому тег используем, чтобы:

Оба тега, и ноиндекс, и нофоллоу отлично чувствуют себя, когда их ставят рядом друг с другом. Пример их совместного использования:

Такая ссылка не передает вес по мнению поисковых систем, кроме того, Яндекс еще и не видит анкор. Но как и было сказано выше, совсем необязательно закрывать ссылки тегом noindex, это бессмысленно. Вы так сможете запретить индексировать анкор, но не саму ссылку. Самой ссылке хватает тега nofollow. Но несмотря на это, многие оптимизаторы (в большей степени — новички), страхуясь, закрывают ссылку обеими тегами — nofollow noindex. Они лишь делают лишнюю работу — толка от нее никакого, задачи этих тегов разные. Просмотрите любую мою статью (к примеру эту — Работа копирайтинг, рерайтинг и свободная продажа статей), ни одна ссылка там не закрыта тегом ноиндекс. Не доверяете мне, загляните на блог опытного оптимизатора. И школа Старт Ап, учащая своих студентов закрывать все ссылки ноиндексом, ошибается. На десерт: сеомания и сеомаразм современных оптимизаторов Исключительно для тех, кто дочитал до этих строг, я делюсь эксклюзивной информацией, которая, впрочем, известна опытным оптимизаторам, они ее и не скрывают, но не особо ей афишируют. Новички-оптимизаторы занимаются настоящим маразмом: они все внешние ссылки с сайта прячут внутрь тега и атрибута noindex, nofollow. Или хуже того: вообще на страничке нет ни одной внешней ссылки, боясь потерять «драгоценный» тИЦ. Спрашивается, зачем это делать, зачем так бояться потерять немного веса со страницы? Что, от этого действия сильно упадет тИЦ сайта или PR странички? Или страницу невозможно будет вывести в топ по СЧ или НЧ-запросам? Глупости. Не нужно жадничать: 1-2 внешние ссылки со странички только улучшат доверие к ней со стороны поисковых систем, и сейчас я вам это докажу. СеомаразмЛюбой текст, написанный кем-либо, должен содержать ссылки на источники, которые использовались при его написании, иначе возникнут сомнения по поводу достоверности излагаемого материала. Сами посудите, вы бы стали доверять книжке, у которой в списке литературы стояло бы 1-2 источника? Вдумайтесь, даже у маленькой брошюрки в источниках находится 10-20 материалов. Как вообще определить, можно ли доверять информации в статье? Если мысли в тексте подкрепляются авторитетным мнением, то доверять можно. Вспомните про википедию, любая статья в ней содержит море ссылок, а если их недостаточно, то модераторы удаляют материал. Также и с любой статьей на вашем сайте: если у вас не будет стоять достаточно ссылок на сторонние АВТОРИТЕТНЫЕ ресурсы, то цена такому материалу нулевая! В первую очередь, вы должны заботиться о читателях, поэтому руководствуйтесь двумя правилами:

И еще: активно перераспределяйте вес между ссылками, закрывая некоторые nofollow (но не noindex — снова напоминаю, это бессмысленно). Нужные внешние ссылки оставляйте открытыми, а ненужные закрывайте, чтобы вес доставался только первым. Сео-оптимизация в случае с noindex nofollow должна быть правильной. Надеюсь, из моей статьи стало понятно как правильно и неправильно использовать ноиндекс и нофоллоу СОЗДАНИЕ И НАСТРОЙКА ФАЙЛА HTACCESS Htaccess (HyperText Access) представляет собой простой файл конфигурации, который позволяет дизайнерам, разработчикам и программистам, изменять конфигурацию веб-сервера Apache, чтобы реализовать дополнительную функциональность. Такая функциональность может включать в себя перенаправления пользователей, изменение URL, обеспечение защиты паролем директорий и многое другое Итак, начнем ... Создание и загрузка файла .htaccess Создать файл .htaccess очень просто. Откройте Блокнот или аналогичный текстовый редактор, добавьте код и сохраните файл как обычно вы это делаете. Например, вы можете назвать его: htaccess.txt

.htaccess

Использование .htaccess Важно помнить, что файл .htaccess будет влиять на каталог в котором он находится, и на все подкаталоги. Поэтому, если вы добавили свой файл .htaccess в корневой каталог веб-сайта, то это повлияет на все имеющиеся на сайте папки:

# Комментария

Вы можете изменить файл, который открывается по умолчанию в каталоге, обычно это файл с именем index (index.html, index.php и т.д.):

Вы можете перенаправить пользователей на собственную страницу ошибок при их возникновении:

Удаляем WWW из адреса сайта Чтобы удалить "WWW" из адреса вашего сайта, используйте следующий код:

Файл .htaccess наиболее часто используется, чтобы ограничить или запретить доступ к отдельным файлам и папкам, и вы можете сделать это следующим образом.:

Вы изменили адреса страниц, но не хотите терять посетителей? Тогда попробуйте:

С помощью следующего кода вы можете указать адрес электронной почты, по умолчанию, для администратора сервера:

Если вы хотите, например, перенаправить пользователей использующих планшет к определенной веб-странице или каталогу, то можно использовать следующие правила:

Если вы не хотите, чтобы картинки с вашего сайта использовали на других сайтах или просто хотите уменьшить трафик. Поэкспериментируйте с этим кодом:

Если вы хотите заставить пользователей загружать определенные типы файлов, а не просматривать их в браузере, то вы можете использовать это:

Если вы хотите, чтобы ваши ссылки было немного легче читать (т.е. изменить content.php?id=92 на content-92.html), Вы могли бы реализовать следующие правила «переписывания»:

Это всегда полезно для тех, кто только что установил SSL-сертификат:

Если вы хотите активировать SSI для HTML и SHTML-файлов, то попробуйте:

Для тех, кто хочет изменить текущую кодировку и язык:

Блокировка нежелательных поситителей Если вы хотите заблокировать нежелательных посетителей переходящих с определенного веб-сайта или ряда сайтов, то вы можете использовать:

При помощи следующего метода, вы можете сохранить траффик путем блокирования определенных роботов и пауков, которые бродят по вашему сайту:

Если вы хотите защитить определенные файлы, или даже заблокировать доступ к файлу .htaccess, то используйте следующий код:

По соображениям безопасности, я думаю, очень полезно переименовать файл .htaccess:

В заключении Файл robots.txt — очень важный и нужный инструмент взаимодействия с поисковыми роботами и один из важнейших инструментов SEO, так как позволяет напрямую влиять на индексацию сайта. .htaccess файлы (или "распределенные конфигурационные файлы") позволяют задавать большое количество дополнительных параметров и разрешений для работы веб-сервера в отдельных каталогах (папках), таких как управляемый доступ к каталогам, переназначение типов файлов и т. д, без изменения главного конфигурационного файла. Используйте robots,nofollow и htaccess правильно и с умом. Если у вас есть вопросы — пишите в комментариях.

| ||||||

|

Автор материала:

О материале:

Дата добавления материала: 29.03.2017 в 00:09

Материал просмотрен: 784 раза

Категория материала: ВСЕ О ХОСТИНГЕ И ПО

К материалу оставлено: 0 комментариев

Рейтинг материала

0

| ||||||

| Всего комментариев: 0 | |